AI indholddetektorer. Er de det værd? | AI i erhvervslivet #38

I dag præsenterer udviklere af AI-indholdsdetektorer dem som værktøjer til at beskytte autenticitet. Spørgsmålet er, om de er værd at stole på og investere i? I denne artikel vil vi se på, hvordan AI-indholdsdetektorer fungerer, hvorfor de måske går i arv, hvilke udfordringer de bringer, og de etiske dilemmaer, de rejser.

AI-indholdsdetektorer

AI-indholdsdetektorer er baseret på sprogmodeller, der ligner dem, der bruges til at generere AI-indhold. De kan opdeles i dem, hvis opgave er at kontrollere oprindelsen af billeder, tekster og musik genereret med støtte fra kunstig intelligens. Hver type “AI-detektor” fungerer lidt forskelligt, men ingen af dem kan skelne med absolut sikkerhed mellem menneskeskabt og AI-genereret indhold.

AI-genererede billeddetektorer spiller en stadig vigtigere rolle på grund af mediernes magt til at generere falske nyheder. De analyserer anomalier, karakteristiske stilarter og mønstre og leder efter tegn efterladt af modeller som DALL-E.

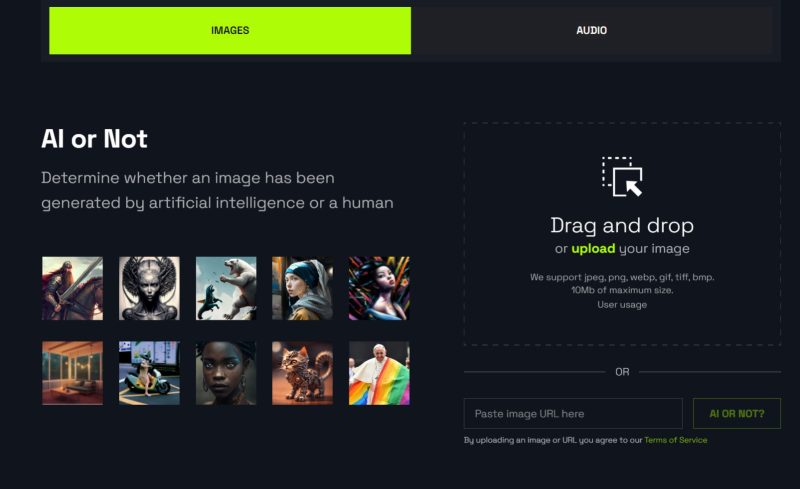

Fremtrædende blandt de detektorer, der bruges til at identificere billeder, er værktøjet “AI or Not” fra Optic, som bruger billeddatabaser genereret af Midjourney, DALL-E og Stable Diffusion. Selvom resultaterne er usikre, er det et skridt mod at udvikle mere præcise identifikationsmetoder i fremtiden.

Kilde: AI or Not (https://www.aiornot.com/)

Bag driften af AI-detektorer, der genkender AI-genererede tekster, ligger avancerede algoritmer, der analyserer strukturen og ordvalget i teksten og derefter genkender AI-specifikke mønstre. De gør brug af:

- klassifikatorer – en algoritme, der klassificerer tekst og tjekker stil, tone og grammatik. For eksempel kan en produktbeskrivelse, der kunne passe til ethvert produkt af sin type, blive klassificeret som en AI-creation,

- indlejringer (embeddings) – numeriske repræsentationer af ord, der gør det muligt for maskiner at forstå konteksten af deres brug. Det er takket være dem, at programmet “forstår”, at en tekst med et monoton valg af ord kan være værket af AI,

- perplexitet – som er et mål for uforudsigeligheden af en tekst. Tekster skrevet af mennesker har tendens til at have højere perplexitet, selvom tekster, der er iboende enkle, utilitaristiske i typisk form, eller skrevet af udlændinge, kan blive fejlagtigt klassificeret som AI-genererede,

- diversitet (burstiness) – denne faktor beskriver variabilitet i sætningslængde og struktur. Mennesker har tendens til at skrive mere varierede tekster end kunstig intelligens.

De ovennævnte elementer bruges sammen af AI-indholdsdetektorer til at vurdere, om vi har med menneskeskabt eller maskinlavet tekst at gøre.

Hvorfor bruge AI-indholdsdetektorer?

AI-indholdsdetektorer arbejder inden for en række områder – fra uddannelse til marketing og rekruttering. Her er de vigtigste grunde til at have dem som et værktøj til at hjælpe med evaluering, men ikke som definitive beviser på, om indholdet er genereret:

- Identifikation af AI-modificerede fotos af kendte personer – for at opdage, om fotoet viser en reel situation,

- Forebyggelse af desinformation – I forbindelse med bekæmpelse af desinformation hjælper effektive AI-indholdsdetektorer sociale mediemoderatorer med at opdage spredning af falske oplysninger for at identificere og eliminere gentagne indhold genereret af bots,

- Begrænsning af offentliggørelse af lavværdi-tekster – AI-indholdsdetektorer kan hjælpe udgivere med at afvise tekster, der indeholder generisk information genereret af ChatGPT, Bing eller Bard efter at have indtastet en simpel forespørgsel.

Det er dog værd at huske, at tekstens oprindelse ikke er grundlaget for Googles nedsættelse af en sides rangordning. Googles Search Center-blog siger, at det er afgørende for Google at “belønne kvalitetsindhold uanset hvordan det er skabt […]. Automatisering er længe blevet brugt til at generere nyttigt indhold, såsom sportsresultater, vejrudsigter og transskriptioner. AI kan åbne op for nye niveauer af udtryk og kreativitet og være et nøgleværktøj til at støtte oprettelsen af stort webindhold.”

Ureliabilitet af AI-indholdsdetektorer. Virkelighed eller myte?

Selvom AI-indholdsdetektorer er allestedsnærværende, kan deres effektivitet være tvivlsom. De vigtigste problemer er:

- lav effektivitet i at opdage AI-indhold,

- problemer med falske positiver, samt

- vanskeligheder med at tilpasse detektorer til hurtigt diversificerende og forbedrende nye AI-modeller.

Tests udført af OpenAI viste, at deres klassifikator kun genkendte GPT-genereret tekst 26% af tiden. Et interessant eksempel på generatorernes ureliabilitet kan ses i et eksperiment udført af TechCrunch, som viste, at GPTZero-værktøjet korrekt identificerede fem ud af syv AI-genererede tekster. Mens OpenAI-klassifikatoren kun identificerede én.

Kilde: GPTZero (https://gptzero.me/)

Derudover er der en risiko for at modtage et falsk positiv, det vil sige at identificere tekst skrevet af et menneske som AI-genereret. For eksempel blev begyndelsen af det andet kapitel af Miguel de Cervantes’ Don Quixote markeret af OpenAI-detektoren som mest sandsynligt skrevet af kunstig intelligens.

Mens fejl i analysen af historiske litterære tekster kan betragtes som en underholdende kuriositet, bliver situationen mere kompliceret, når vi ønsker at bruge detektorer som værktøjer til at evaluere tekster. Den amerikanske forfatning blev markeret af ZeroGPT som 92,15% skrevet af kunstig intelligens. Og ifølge en undersøgelse offentliggjort af forskere fra Stanford University blev 61% af TOEFL-essays skrevet af ikke-indfødte engelsktalende studerende klassificeret som AI-genererede. Desværre er der ingen data om, hvor høj procentdelen af tekster, der fejlagtigt klassificeres som positive på andre sprog, er.

Et andet problem er ændringen af klassifikation ved efterfølgende kørsel af detektoren. Dette skyldes, at det ofte sker, at en detektor som ZeroGPT eller Scribbr ændrer klassifikationen af tekstfragmenter, som den markerer som AI-genererede én gang og som menneskeskrevne en anden gang.

Kilde: Scribbr (https://www.scribbr.com/ai-detector/)

AI-billed- og videodetektorer bruges primært til at identificere deepfakes og andet AI-genereret indhold, der kan bruges til at sprede desinformation.

Nuværende detektionsværktøjer som Deepware, Illuminarty og FakeCatcher giver ikke testresultater om deres pålidelighed. I den juridiske kontekst af at opdage AI-genereret visuelt materiale er der initiativer til at tilføje vandmærker til AI-billeder. Dette er dog en meget upålidelig metode – man kan bare nemt downloade et billede uden vandmærke. Midjourney tager en anden tilgang til vandmærkning og overlader det til brugerne at beslutte, om de vil vandmærke et billede på denne måde.

Undgåelse af AI-detektion. Er det muligt, og hvordan?

Entreprenører bør være opmærksomme på, at AI-indholdsdetektorer ikke er en erstatning for menneskelig kvalitetsvurdering og ikke altid er pålidelige. Deres praktiske vedligeholdelsesproblemer kan udgøre betydelige vanskeligheder, ligesom det at forsøge at undgå at få dit indhold klassificeret som AI-genereret. Især når AI blot er et værktøj i hænderne på en professionel – det vil sige, det er ikke “indhold genereret af AI”, men snarere “indhold, der blev skabt i samarbejde med AI.”

Det er relativt enkelt at tilføje nogen til de genererede materialer, så måden de er skabt på, er virkelig svær at opdage. Hvis den person, der bruger generativ AI, ved, hvilken effekt der skal opnås, kan de simpelthen manuelt justere resultaterne.

Det grundlæggende spørgsmål ligger i årsagen bag vores ønsker om at undgå detektion, hvis indholdet blev genereret af AI.

- Hvis dette er et etisk spørgsmål og vedrører for eksempel ophavsret til offentliggjort videnskabelig forskning – må man stole på den professionelle etik hos forskeren og det ansvarlige brug af AI-baserede værktøjer.

- Hvis arbejdsgiveren ønsker, at medarbejderne skal fravælge brugen af AI – forbliver der en kontraktlig aftale om brugen af generativ kunstig intelligens.

Det rejser også spørgsmålet om, hvorvidt vi ønsker at fremme ansvarlig brug af AI gennem forbud og modstandere (ZeroGPT og GPTZero!), eller gennem en værdsættelse af gennemsigtighed, tillidsopbygning og ærlig brug af avancerede teknologier.

Kilde: ZeroGPT (https://www.zerogpt.com/)

Sammenfatning

Svaret på spørgsmålet om, hvorvidt AI-indholdsdetektorer er værd at bruge, er langt fra klart. AI-indholdsdetektorer er stadig under udvikling, og deres fremtid er svær at forudsige. Én ting er sikker – de vil udvikle sig sammen med udviklingen af AI-teknologi. Fremskridt inden for AI, herunder den stigende evne hos sprogmodeller til at efterligne menneskelig skrivestil, betyder, at AI-indholdsdetektion kan blive endnu mere kompliceret. For virksomheder er dette et tegn på at følge disse udviklinger og ikke kun stole på værktøjer, men på deres vurdering af indhold og dets egnethed til det formål, det blev skabt til. Og at bruge den hurtigt udviklende kunstige intelligens klogt.

Hvis du kan lide vores indhold, så bliv en del af vores travle bier-fællesskab på Facebook, Twitter, LinkedIn, Instagram, YouTube, Pinterest, TikTok.

Robert Whitney

JavaScript-ekspert og instruktør, der coacher IT-afdelinger. Hans hovedmål er at hæve teamproduktiviteten ved at lære andre, hvordan man effektivt samarbejder, mens man koder.

Recent Posts

AI’s rolle i indholdsmoderation | AI i erhvervslivet #129

Virksomheder kæmper med at håndtere en stor mængde indhold, der offentliggøres online, fra sociale medieindlæg…

Sentimentanalyse med AI. Hvordan hjælper det med at drive forandring i erhvervslivet? | AI i erhvervslivet #128

I en tid med digital transformation har virksomheder adgang til en hidtil uset mængde data…

Bedste AI transskriptionsværktøjer. Hvordan omdanner man lange optagelser til præcise resuméer? | AI i erhvervslivet #127

Vidste du, at du kan få essensen af en fler timers optagelse fra et møde…

AI videoproduktion. Nye horisonter inden for videoinholdproduktion for virksomheder | AI i erhvervslivet #126

Forestil dig en verden, hvor dit firma kan skabe engagerende, personlige videoer til enhver lejlighed…

LLMOps, eller hvordan man effektivt håndterer sprogmodeller i en organisation | AI i erhvervslivet #125

For fuldt ud at udnytte potentialet i store sprogmodeller (LLMs) skal virksomheder implementere en effektiv…

Automatisering eller augmentation? To tilgange til AI i en virksomhed | AI i erhvervslivet #124

I 2018 havde Unilever allerede påbegyndt en bevidst rejse for at balancere automatiserings- og augmenteringsevner.…